Die Wordpress robots.txt

Die robots.txt ist eine kleine Textdatei, die dabei helfen kann, bestimmte Bereiche der Website oder des Blogs für Suchmaschinen-Robots unzugänglich zu machen. Zumindest in der Theorie!

Mit den Anweisungen innerhalb dieser Datei „sagt“ man den Crawlern lediglich, dass sie in den aufgeführten Verzeichnissen keine für sie relevanten Informationen finden und sie sich die Arbeit sparen können, hier nach Inhalten zu suchen. Die Bots der großen Suchmaschinen und auch verschiedene Tools halten sich daran. Spam-Bots und manch exotischere Suchmaschine ist das allerdings egal.

Wichtig: Die robots.txt dient nicht dazu, um eine Indexierung von Seiteninhalten zu steuern! Durch einen Eintrag in dieser Datei wird nicht verhindert, dass Informationen bei Google, Bing & Co. gefunden werden können. Mit der robots.txt wird lediglich das Crawlen der hier aufgeführten Inhalte vermieden.

Die robots.txt & Suchmaschinenoptimierung

Seiteninhalte

Relevant fürs SEO, der Suchmaschinenoptimierung, ist – nicht nur für WordPress – die robots.txt weniger. Die Angabe des Pfandes zur sitemap.xml hat sicher noch eine Bedeutung für Suchmaschinen ohne Webmastertools bzw. Search Console und kann somit hier noch als sinnvoll betrachtet werden.

Alle anderen Einträge helfen bei umfangreichen CMS-Lösungen vielleicht, die Serverlast etwas in den Griff zu bekommen. Bei sehr großen Seiten kann der Ausschluss bestimmter Bereiche der Webseite dem sogenannten Crawl Budget zu Gute kommen, indem das Crawlen überflüssiger Inhalte vermieden wird und der Robot sich auf die wesentlichen Inhalte konzentrieren kann.

In der Regel entdeckt man im Netz aber deutlich mehr Fehler die mit der robots.txt gemacht werden, als wirklich relevante Einstellungen. Im Zweifel ist hier weniger mehr … und Fehler schleichen sich schnell ein.

Keine robots.txt anzulegen ist meist deutlich Vorteilhafter, als eine syntaktisch fehlerhafte oder eine mit falschen Einträgen!

Was gehört in die robots.txt für WordPress

# Kommentar: Hier ist der Pfad zu meiner sitemap.xml Sitemap: https://www.example.com/sitemap.xml Sitemap: https://www.example.com/sitemap-2.xml # Wer Adsense einsetzt sollte dem Google-Mediapartners-Crawler auf alle Inhalte Zugriff gewähren, um nicht in den Verdacht zu geraten, hier etwas verstecken zu wollen User-agent: Mediapartners-Google* Disallow: # WordPress-typische Einstellungen innerhalb der robots.txt User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

- Der Pfad zur sitemap.xml (sofern vorhanden). Hier reicht der Verweis auf eine Index-Sitemap, es können aber auch mehrere Sitemaps aufgelistet werden.

- Den Zugriff für „Mediapartners-Google“ auf alle Inhalte.

- Das Crawlen unterhalb von /wp-admin, außer /wp-admin/admin-ajax.php

Wie erstelle ich bei WordPress eine robots.txt

Es gibt hierfür einige Plugins, die allerdings nicht wirklich gebraucht werden. Eine virtuelle Standard robots.txt erstellt WordPress automatisch. Diese muss in der Regel nicht angefasst werden, da sie für die meisten Fälle absolut ausreichend ist. Auch sitemap-Erweiterungen und andere Plugins sind durchaus in der Lage, dort, falls nötig, ihre Eintragungen hinzuzufügen. Die robots.txt lässt sich im Browser unter http://meine-url.de/robots.txt aufrufen.

Wer manuell eine robots.txt anlegen möchte, kann diese mit einem beliebigen Text-Editor (der vorhandene Editor unter Windows ist völlig ausreichend) erstellen und unter dem Namen robots.txt abspeichern.

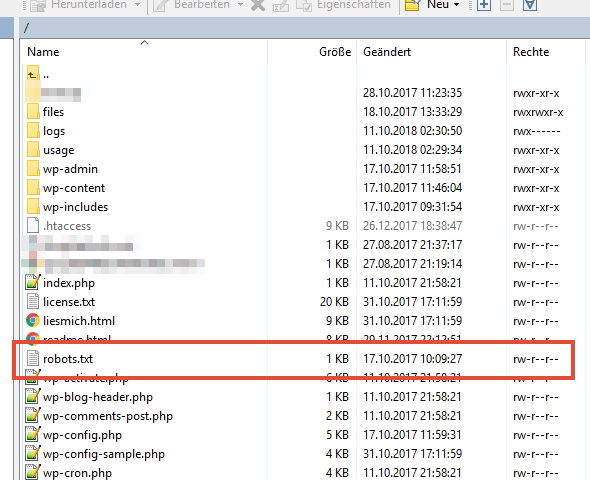

Wo wird die erstellte robots.txt abgelegt?

Mit Hilfe eines FTP-Programms wird diese Textdatei nun auf den eigenen Webspace geladen. Sie muss parallel zur wp-config.php und der .htaccess im root-Verzeichnis der WordPress-Installation liegen. Sie muss letztendlich unter http://meine-url.de/robots.txt erreichbar sein.

Wie verhindere ich, dass bestimmte Seiten bei Google & Co. zu finden sind?

Das „Zauberwort“ heißt noindex! Nur wenn auf einer Seite (einem Webdokument, einer HTML-Seite usw.) per Noindex-Robots-Anweisung oder per X-Robots-Tag (siehe Bilder und andere Dateien vom Indexieren durch Google ausschließen hier im Blog) den Suchmaschinen mitgeteilt wird, dass diese Inhalte nicht indexiert werden dürfen, lassen sich diese auch bei Google, Bing & Co. als nicht auffindbar kennzeichnen.

Hierbei ist unbedingt darauf zu achten, dass diese Seiten crawlbar sein müssen. Sie dürfen also nicht per robots.txt für die Bots ausgeschlossen werden, da diese sonst nicht „sehen“, dass auf diesen Seiten eine Noindex-Anweisung erfolgt.

<head> ... <meta name="robots" content="noindex" /> </head> <body> ...

Die robots-Anweisung im Bereich der Metadaten ist hierbei für alle Websites/HTML-Seiten die einfachste und gängigste Methode. Da in PDFs, Bildern usw. diese Header-Angaben so nicht möglich sind, kann hier auf das X-Robots-Tag gesetzt werden, welches im HTTP-Header eingetragen wird.

Ein Ausschluss (wie man ihn sehr oft sieht) per robots.txt heißt nicht, dass diese Inhalte nicht in Suchmaschinen gefunden werden können. Gibt oder gab es auch nur einen Verweis im World Wide Web auf dieses Dokument, so besteht auch die Möglichkeit dieses per Suchanfrage in einer Suchmaschine auch zu finden.

Fazit

- Bei WordPress besser keine robots.txt manuell anlegen, da das System bereits eine Standard-Datei hierfür bereit hält.

- Eine robotos.txt dient nicht der Steuerung der Indexierung von Webinhalten in Suchmaschinen.

- Möchte man eine Indexierung einzelner Inhaltsseiten durch Google, Bing & Co. vermeiden, dann dies per Robots-Noindex-Anweisung einrichten und nicht in der robots.txt. Die meisten SEO-Plugins halten hierfür eine entsprechende Auswahlmöglichkeit bereit

Weitere Informationen und Grundlagen zur robots.txt unter wiki.selfhtml.org und support.google.com.

4 Responses

Es sollte einfach eine ferige ROBOTS.TXT für WordPress-Installationen geben!

Ich denke als „WordPress-Experte“ weißt du, dass WP diese automatisch erstellt, wenn keine vorhanden ist.

Ich meinte in diesem Beitrag. Die Standardeinträge sind ungenügend.

Wieso? Was fehlt dir?